En este comienzo de año, el anuncio de dos cámaras, la Fuji X-Pro 1 y la Nikon D800E, han vuelto a levantar la polémica sobre la necesidad de usar un filtro antialiasing para eliminar posibles problemas de Moiré en fotografías digitales (sí, es un problema exclusivo de la fotografía digital). Con todo lo que se estaba escribiendo en los foros pensé que tal vez fuese una buena idea explicar que es dicho efecto, y cómo se ha intentando solucionar a lo largo de la historia con o sin filtro antialiasing (los dos modelos de cámara que he comentado antes son solamente los dos últimos ejemplos). Obviamente la idea era tan evidente que alguien ya se me adelantó: The Naked Sensor.

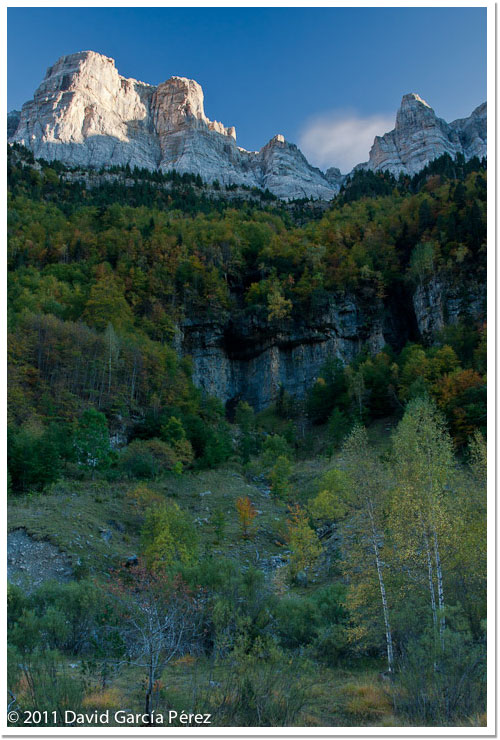

Cae el sol en Monte Perdido. [Cámara: Canon 40D. Lente: Canon 17-40Lf4. Filtro: Polarizador Heliopan y filtro degradado Lee de 3 pasos. Exposición: ISO100, f11 y 0.5 seg. Toma sacada con trípode, disparador remoto, y espejo levantado.]. © David García Pérez 2011.

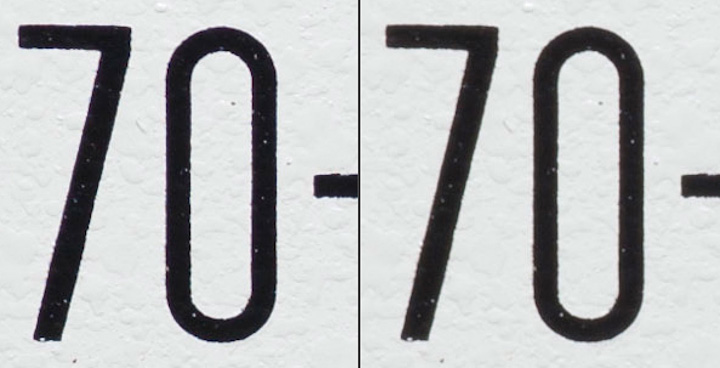

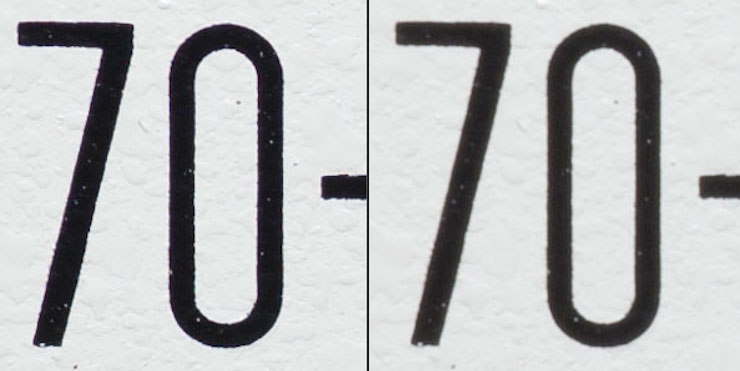

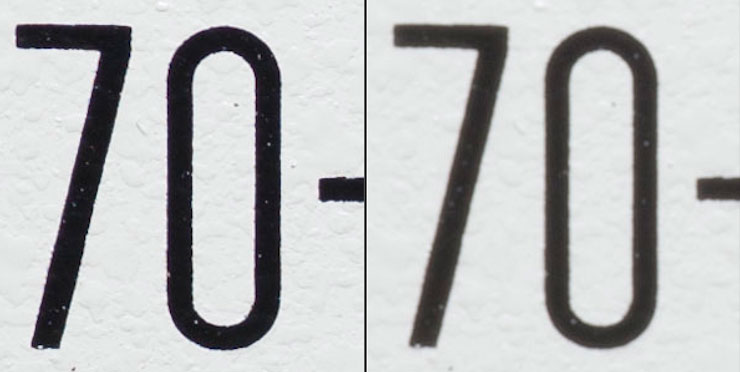

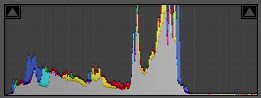

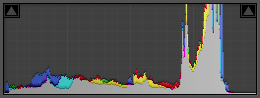

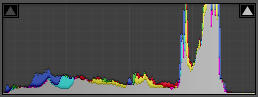

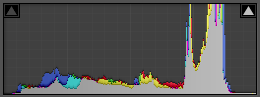

Ya en su momento hablé de que los sensores fotográficos digitales suelen estar dispuestos en lo que se conoce como patrón de Bayer. En ese pequeño artículo comentaba que a través de algoritmos de demosaicing se recreaba la imagen a partir del archivo RAW generado por la cámara. Esto funciona muy bien en la mayoría de las ocasiones, pero puede presentar graves problemas si la imagen contiene patrones repetitivos, como en los ejemplos que podemos ver aquí.

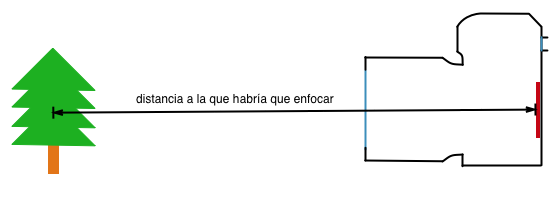

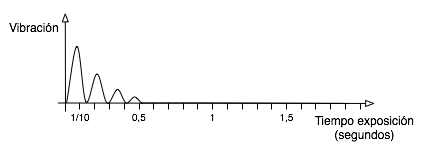

La mayor parte de los fabricantes de cámaras digitales optan por emplear lo que se denomina un filtro antialiasing justamente delante del sensor. La misión principal de este filtro es de hacer la imagen un pelín más borrosa de lo que llega de en la lente. De esta forma, lo que conseguimos es que los ejes del patrón regular que causan el efecto Moiré no sean tan perfectos, haciendo que después el algoritmo de demosaicing no cometa errores al reconstruir la información proveniente del fichero RAW.

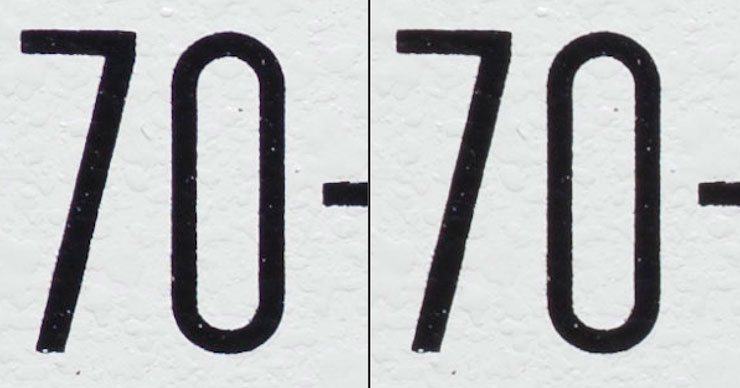

Y aquí es donde empieza la polémica, tal y como habéis leído en el párrafo anterior, nuestro fantástica lente, que tanta nos costó, que tan nítida dicen que es, no puede ser usada a su máximo potencial dado que justamente delante del sensor hay un pequeño filtro cuyo única intención es emborronar un poco la imagen, lo suficiente para que no se produzcan efectos Moiré en el hipotético caso de que estemos fotografiando patrones regulares.

En el mundo de los sensores digitales para cámaras de medio formato (sensores mucho más grande que un 35mm usadas en cámaras de casas como Phase One ó Hasselblad, entre muchas otras), es típico que los sensores no lleven ningún filtro antialiasing. Según fabricantes como Phase One debido a que estos sensores cada vez tienen más megapixeles, cada vez es más difícil encontrar un patrón en la vida real que produzca un efecto Moiré. En contra, la nitidez que ganan las imágenes, los detalles minúsculos que se pueden apreciar en ellas, consiguiendo ese aspecto característico de foto de medio formato, hace que a muchos profesionales se les olvide cualquier mínima preocupación que puedan tener por su ausencia.

En el mundo de sensores de 35 mm y hermanos más pequeños, las primera cámaras sin filtro antialiasing vino de la mano de mítica Kodak, ahora mismo en bancarrota, con su cámara digital DCS 14n, cámara que no tuvo mucho éxito comercial. Leica seguiría los pasos de Kodak (es más, usa sensores fabricados y diseñados por ellos), en sus modelos M8 y M9 (en este caso las malas lenguas comentan que realmente la decisión de no usar estos filtros delante del sensor vino debida a que no tenían espacio físico para ellos, siempre y cuando Leica quisiese mantener la compatibilidad con su mítica serie de lentes M).

Un caso particular es Sigma y su serie de cámaras que utilizan un sensor Foveon. Estos sensores no utilizan un patrón de Bayer, cada pixel es capaz de recoger simultáneamente los valores de rojo, azul y verde, con lo cual son completamente inmunes al efecto Moiré. El precio y su bajo rendimiento a ISOs altos han hecho que estas cámaras no tuviesen un gran éxito en el mercado.

Ricoh introdujo el año pasado para su sistema de cámaras modules un nuevo módulo que incorpora un sensor sin filtro Antialising. La solución de este sistema de cámaras de Ricoh dónde el sensor va asociado a las ópticas, tampoco ha cuajado mucho en el mercado.

Una compañía que fue todo un referente en el mundo analógico, al igual que Kodak, es Fuji. Pero a diferencia de la compañía americana, esta empresa japonesa le ha visto los dientes al lobo digital y se ha dedicado abrirse un hueco muy rentable en un mercado muy competitivo. En busca del fotógrafo que esta dispuesto en pagar por un equipo de alta calidad y pensado para él (algunas veces te preguntas si quienes diseñan cámaras digitales las usan después, solucionarían en grandes problemas de usabilidad que presentan muchas de las marcas supuestamente líderes del mercado), consiguió un gran éxito con su cámara X100, éxito que esperan continuar con la hermana mayor de la misma que sacan este año, la X-Pro1. Este último modelo tampoco lleva filtro antialiasing, pero incorpora un patrón de Bayer particular, bajo lo que ellos denominan el X-Trans CMOS. Este patrón intenta añadir algo de aleatoridad, haciendo que la probabilidad de que en la vida real nos encontremos un patrón que provoque Moiré sea muy baja.

Y llegamos al último fabricante en jugar a este juego, Nikon, que con su D800E ha llamado la atención de todo el mundo. Realmente esta cámara si que tiene un filtro antialiasing, lo que pasa es que justamente después de este le ponen otro que anula su efecto, no sé exactamente por qué, pero obviamente sus motivos tendrán. Pero Nikon no se la quiere jugar, no se quiere arriesgar a que los clientes no les compren las cámaras por que todo el mundo empiece a ver Moiré en sus fotos. Por ello la Nikon D800E viene acompañada por una hermana gemela, la Nikon D800, que no tiene el filtro antialiasing anulado. De esta forma, Nikon deja en las manos del comprador la decisión a tomar de que cámara mejor le conviene a su fotografía (a mí que me gusta la fotografía de paisaje, desde luego iría de cabeza por la D800E, pero primero esperaría a ver los análisis de la misma).

Es bastante curioso, pero que un fabricante mayoritario como Nikon lanza una cámara sin filtro antialiasing justamente después de que Adobe anunciase el Lightroom 4, que incorpora una herramienta de corrección de Moiré en la misma. Digo curioso por qué Nikon suele ser uno de los fabricantes que da poca información a terceras empresas de como abrir sus ficheros RAW propietarios, teniendo estas que hacer ingeniería inversa.