La gente que me conoce notará que hay cierto cinismo por mi parte al hacer un artículo de sobre como funciona un sistema de autoenfoque, más que nada por que yo para el 90% de mis fotos enfoco la cámara de forma manual.

Anochecer sobre el Aneto [Canon 5D Mark II con Canon 70 -200f4L IS . Toma sacada a IS0100, f11 y 1 seg. Trípode y disparador remoto utilizado]. © David García Pérez 2014.

. Toma sacada a IS0100, f11 y 1 seg. Trípode y disparador remoto utilizado]. © David García Pérez 2014.

La idea de este artículo me surgió un pelín de rebote. Estaba leyendo una entrevista a Jay Kelbley de Samsung sobre el anuncio de la nueva NX1. Durante la lectura de dicha entrevista hubo un párrafo que me llamó la atención. El entrevistador le pregunta al representante de Samsung si teniendo 200 puntos de enfoque por detección de fase en el propio sensor eso no hace que la imagen pierda calidad dado que los píxeles, en el sensor, usados para hacer sensor de autoenfoque no captaban tan bien la luz como los píxeles normales (el entrevistado aclararía que el porcentaje de píxeles afectados por esto es mínimo y que no afecta la imagen, cálculos a ojo del entrevistador ponen ese porcentaje por debajo del 1% de todos los píxeles del sensor).

En ese momento me di cuenta de que realmente no sabía como funcionaban dichos sistemas, ni por que al ponerlos en el sensor afectaría a que zonas del sensor no pudiesen captar tan bien la luz como otras zonas. Así que decidí leer un poco sobre el tema, con la inevitable consecuencia de terminar por convertirse en artículo para este blog.

Historia

Como muchas de las ideas de al fotografía actual, la historia de los sistemas de autoenfoque empieza con una marca: Leica. Aunque la época en la que comienza esta historia era conocida como Leitz.

En el año 1960, Leica patentaría los primeros sistemas de autoenfoque. Seguiría jugando con diversas ideas de como hacer un sistema de autoenfoque hasta que en el año 1976 presentarían durante el Photokina la Leitz Correfot, una cámara que utilizaba un sistema de confirmación de enfoque parecido a los sistemas de detección de fase que se emplean en la actualidad (explicación detrás de esta idea más adelante). Esta cámara no dejaría ser un prototipo que no se comercializó, al igual que la reflex que presentarían en el siguiente Photokina en el año 1978 (los Photokina tiene una periocidad de dos años).

Mientras tanto, una compañía americana, Honeywell, poco conocida en el mundo de la fotografía, publicaría durante los 70 cuatro patentes con las ideas de lo que hoy conocemos como sistema de enfoque por detección de fase (“Electronic Focus for Cameras”, por N. Stauffer y D. Wilwerding March, Scientific Honeyweller, Volumen 3, N. 1 Marzo 1982) y que gran parte de las cámaras de hoy en día usan (bueno, una evolución de esas ideas iniciales).

Honeywell no comercializaría una cámara basadas en su idea, que denominaban “Visitronic AF system”. Sería Konica con su Konica C35 AF la primera en comercializar una cámara con dicho sistema (pagando a Honeywell los respectivos derechos de pantente), convirtiéndose al mismo tiempo en la primera cámara producida en masa en comercializarse con un sistema de autoenfoque.

Konica abrió la caja de pandora y otras marcas rápido la seguirían, empezando con la Polaroid SX–70 que se comercializaría el año siguiente, 1978. Está era la primera cámara réflex con sistema de autoenfoque, pero usaría un sistema activo en vez de pasivo como la anterior C35 (un sistema activo emite una luz infraroja o ultrasonidos para ayudar al sistema de autoenfoque a enofocar, a diferencia de los pasivos como el de la C35 que son los que se usan habitualmente hoy en día).

Pero realmente los sistemas anteriores no serían lo que hoy en día entendemos como 100% sistemas de autoenfoque. Simplemente confirmaban que la lente estaba enfocada, pero no había motores que moviesen la lente. No sería hasta el año 1981 que Pentax lanzaría su Pentax ME-F, la primera cámara réflex que tenía un motor que movía el anillo de enfoque de la lente en coordinación con el sistema de autoenfoque. Era un sistema bastante antiestético, dado que los motores eléctricos que movían el anillo de enfoque sobresalían por debajo de la lente.

Nikon seguiría a Pentax con su Nikon F3AF en el año 1983. Pero no sería hasta el año 1985 que Minolta saca su Minolta 7000, la primera cámara que incorporaría tanto motor de autoenfoque como sistema de autoenfoque en el propio cuerpo de la cámara, haciendo que las lentes fuesen mucho más atractivas en cuanto a diseño con respecto a los sistemas de autoenfoque de otras marcas. Esto idea sería seguida por otros fabricantes como Nikon.

Pero Minolta, al igual que casi el resto de fabricantes de cámaras con sistemas de autoenfoque con detección de fase, como Nikon o Canon, tuvieron un pequeño contratiempo económico. Honeywell no le hizo gracia que la gente no pagase por el uso de sus patentes y empezó demandado a Minolta, que se vería obligada a pagar casi 100 millones de euros por el uso de las patentes de Honeywell. Otros fabricantes seguirían la suerte de Minolta.

Canon, a pesar de tener cámaras compactas con sistemas de autoenfoque desde hace años, como la Canon AF35M, no entraría en el mercado de las réflex con sistema de autoenfoque hasta el año 1987, con la introducción de su serie EOS. Aquí volvería a poner los motores de autoenfoque en la lente, de esta vez sin abultados añadidos debajo de la misma. Diseño al que ya todos estamos acostumbrados hoy en día.

Funcionamiento

Aunque hay más sistemas, los algoritmos de detección de autoenfoque por contraste y por detección de fase, que presento a continuación, son los que se emplean en la mayoría de las cámaras de fotografía actuales, ya sea tu teléfono móvil y o tu réflex que te costó como la entrada de un coche de gama alta (algunas incluso como el coche mismo).

Enfoque por contraste

Empiezo explicando la idea de funcionamiento de autoenfoque por contraste dado que es la más sencilla de todas. La hipótesis es muy sencilla: “Una zona de la imagen estará enfocada cuando el contraste es máximo para ese región”.

El algoritmo de enfoque por contraste funciona de la siguiente forma: Primero, en la región de la imagen que quiero que esté enfocada (puede ser una región pequeña o toda la imagen, depende de lo que configuremos) analizo el histograma y saco una medida del contraste de la imagen. Segundo, muevo un pelín la lente en una dirección, si el contraste aumenta, sigo en esa dirección, sino, empiezo a mover el enfoque de la lente en dirección contraria. Sigo haciendo esto mientras el contraste de la zona a analizar aumente, una vez empiece a disminuir, significa que me he pasado, y tengo que volver hacia atrás, hasta encontrar de nuevo ese punto de máximo enfoque.

Tal vez habéis notado que este algoritmo tiene una desventaja principal, la cámara no sabe hacia donde tiene que mover la lente para conseguir enfocar, lo cual puede hacer que se pierda tiempo intentando enfocar la lente en el sentido contrario al deseado, a parte de cuando se alcanza el punto máximo de enfoque, la cámara no la sabe, por lo que necesita pasarse un poco para comprobar que el histograma disminuye su contraste y volver para atrás. En resumen, los sistemas de autoenfoque por contraste son más lentos que los sistemas de enfoque por detección de fase que comento en la siguiente sección.

Pero no todo son desventajas. Como explicaré más adelante, la detección por contraste en cámaras digitales se hace en sobre el propio sensor, lo cual hará que sean mucho más precisos que los sistemas tradicionales de detección de fase (a parte de que no necesitan ninguna calibración), aunque esto está cambiando con los nuevos sistemas de detección híbridos que comentaré más adelante.

Enfoque por detección de fase

La explicación de como funcionan los sistemas de detección de fase es un pelín más complicada que la de contraste y está basada en el siguiente principio: “cuando un punto está enfocado, los rayos de luz provenientes de dicho objeto/zona iluminarán de forma igual puntos opuestos de la lente (la lente está en ”fase“)”.

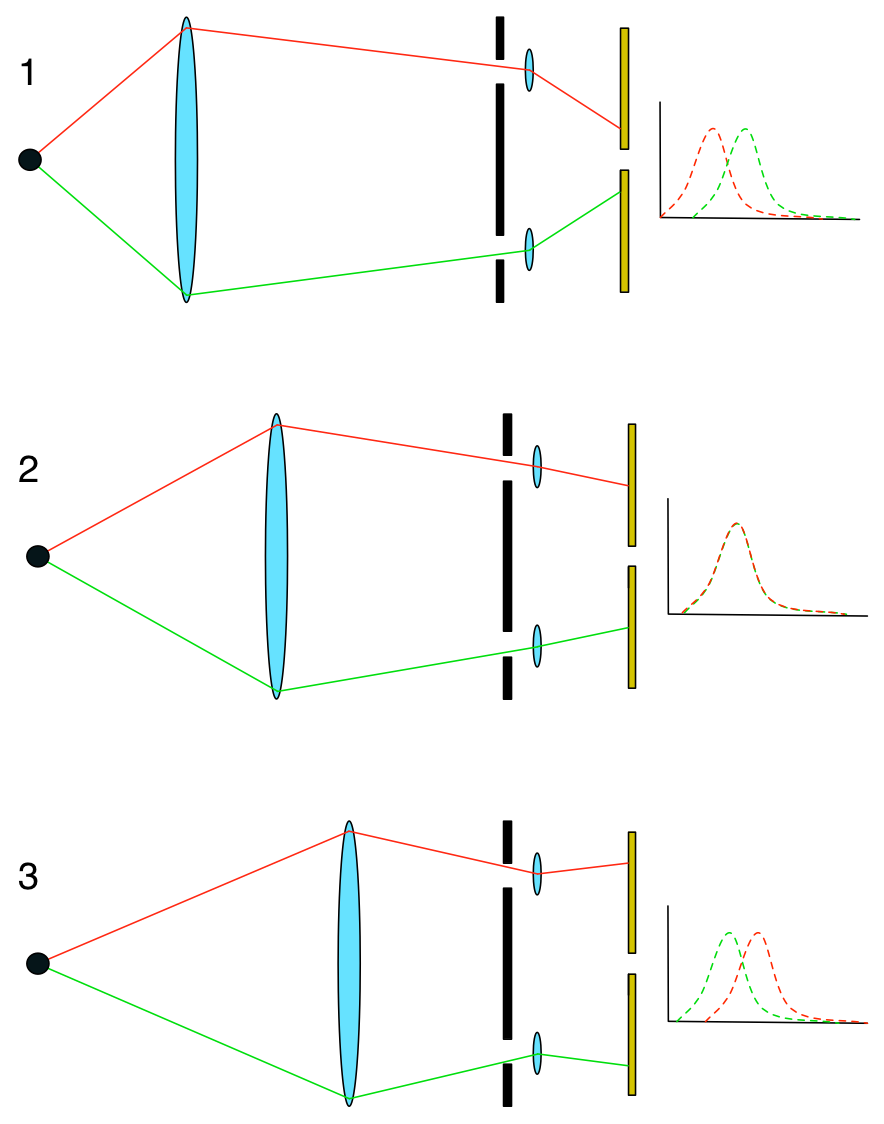

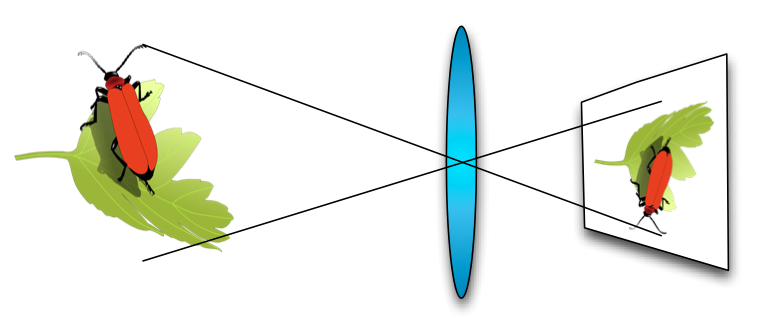

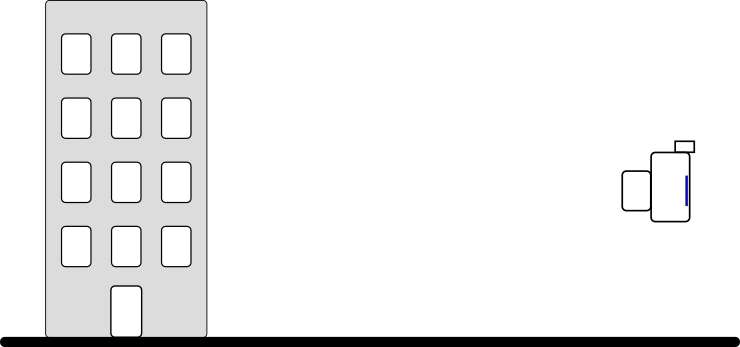

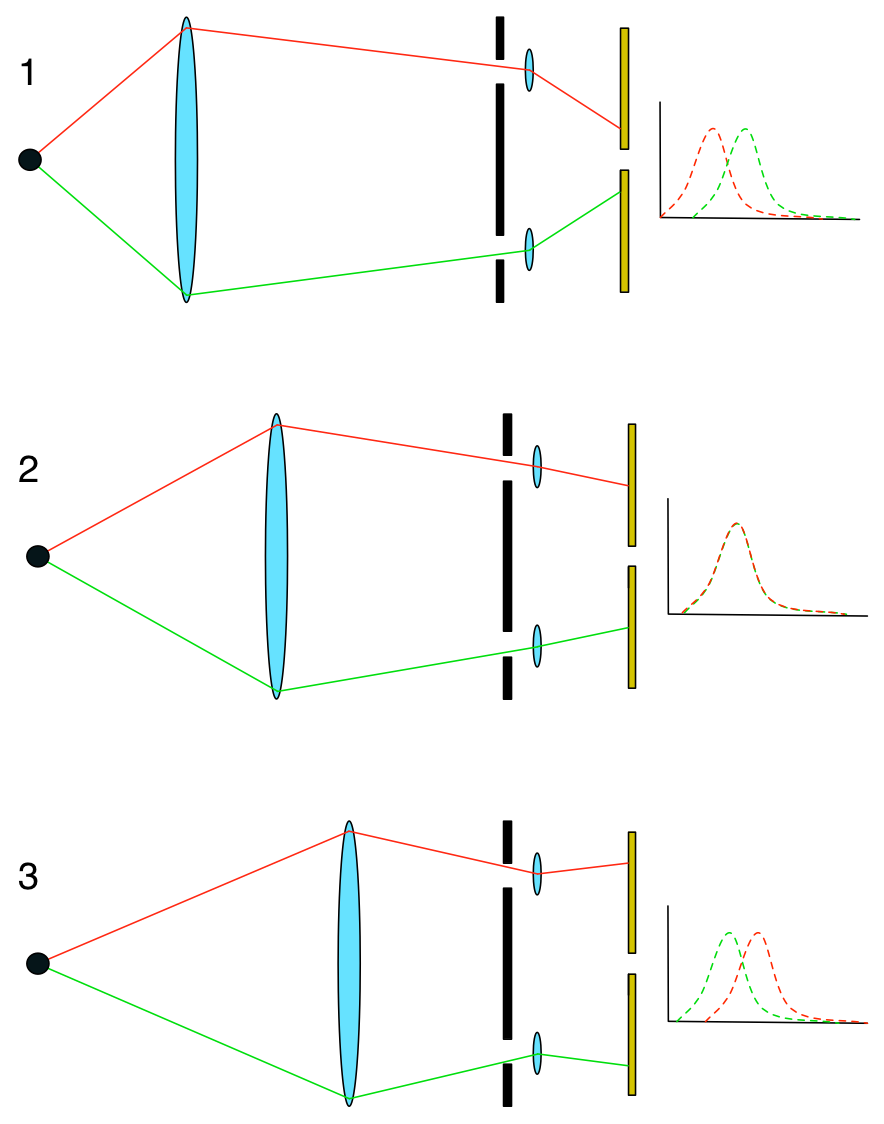

Empleando este principio, los fabricantes de cámara son capaces de crear sensores que que recogen la luz proveniente de los bordes de la lente en diversas zonas de la imagen. Miden la luz proveniente de uno de los bordes con un sensor y del borde diametralmente opuesto con otro (la siguiente figura muestra un esquema de como funciona). Este sistema es capaz de detectar en que sentido se tiene que mover la lente para que esté bien enfocada.

La anterior figura intenta explicar como funciona el sistema de enfoque por detección de fase. A la izquierda tenemos un punto negro que entendemos que es lo que queremos enfocar. Tenemos nuestra lente en el medio que en cada caso pasará de estar enfocada a un punto muy cercano del objeto (1), después correctamente enfocada (2), y por último, demasiado lejos del punto de enfoque ideal (3). La barrera negra con dos agujeros representa como el fabricante es capaz de separar la luz de de dos zonas distintas de la lente (en realizad el fabricante usaran un separador de rayos (beans splitter) que algunas veces veo representado por una pieza óptica en forma de trapecio… pero ya me he olvidado de mis clases de óptica geométrica en la carrera, así que no me hagáis caso). Después del separador de rayos (traducción muy liberal por mi parte) tenemos un par de microlentes que ayudan a enfocar la luz sobre el sensor (los rectángulos amarillos).

Como veis en los diagramas la luz llega a ambos sensores de diferentes zonas de la lente diametralmente opuestas. Analizando la intensidad recibida en ambas sensores y comparando la gráficas la cámara es capaz de saber si la lente está enfocada (2), dado que ambas señales están en “fase” (sobrelapadas), o cuanto de lejos y en que sentido tiene que mover los motores de autoenfoque según lo como sea esa diferencia de fase. Gracias a esto último, hace que los sistemas de detección de fase sean, habitualmente, más rápidos que los sistemas de enfoque por contraste.

Implementaciones en las cámaras

Ahora que tenemos una idea más o menos clara de como estos algoritmos funcionan, veamos como los fabricantes han decidido implementarlos en las cámaras digitales modernas (bueno, modernas al momento de escribir el artículo -finales del 2014-).

Lo obvio, por detección de contraste

Los sistemas de autoenfoque por detección de contraste eran hasta hace unos años usados de forma casi en exclusiva por cámaras de vídeo digitales o cámaras de fotografía compactas, pero la situación cambió bastante con la introducción de cámaras sin espejo, las cuales no podían llevar los sistemas de autoenfoque por detección de fase como veréis en la siguiente sección (también la introducción de liveview forzó a los fabricantes de réflex a añadir esta tecnología en sus cámaras).

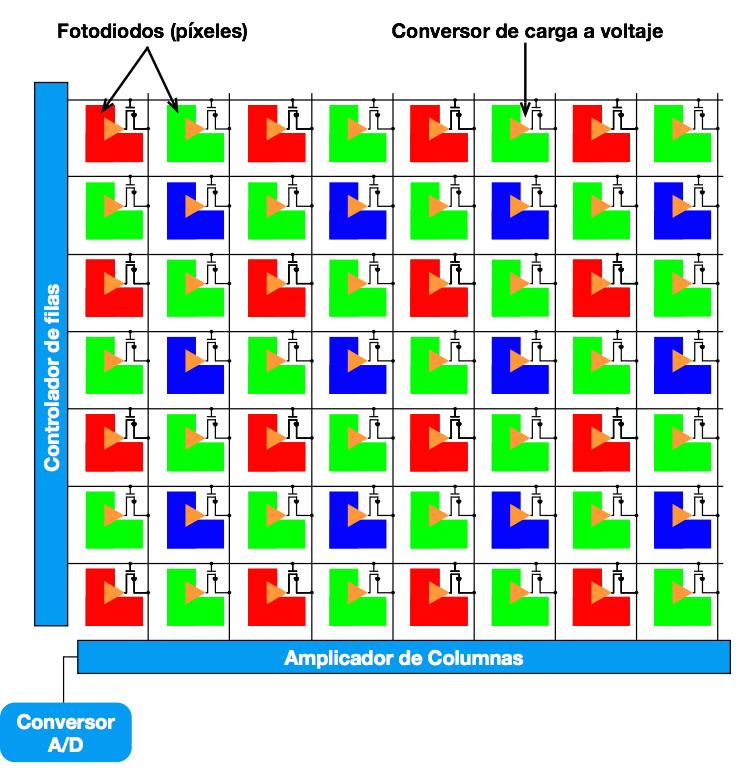

Todas las cámaras actuales ofrecen la posibilidad de enfoque por contraste y básicamente esta se emplea cuando la cámara está en liveview o es una cámara sin espejo (esta frase cada vez es menos cierta, sino, leer hacia el final del artículo la sección "Detección de fase en el sensor digital"). Es el propio sensor el que hace de sensor de autoenfoque. La cámara lee la señal que viene del sensor, del área que queremos tener enfocada, y por software calcula el histograma de la misma y el contraste, y después empieza a mover el motor de autoenfoque tal y como indiqué anteriormente.

Como ya dije el sistema es lento, pero su principal ventaja es que se hace sobre el sensor, así que no hay problemas de calibraciones como comentaré en la siguiente sección, por lo cual será un sistema de enfoque muy preciso.

Montaje típico de detección de fase

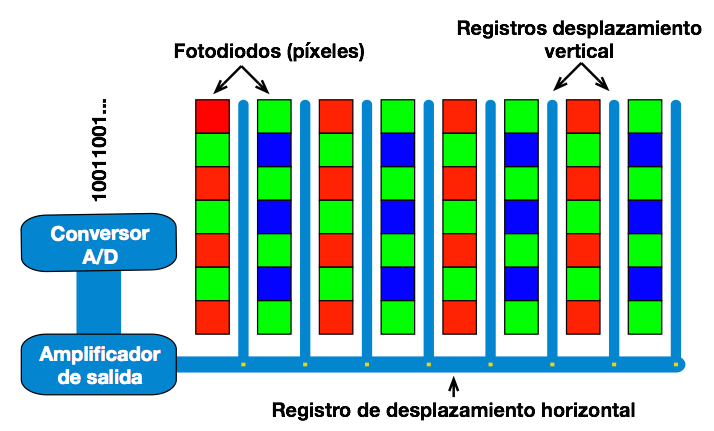

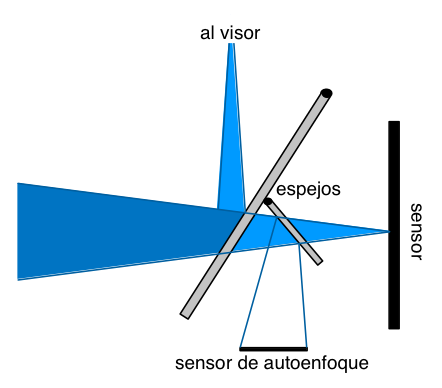

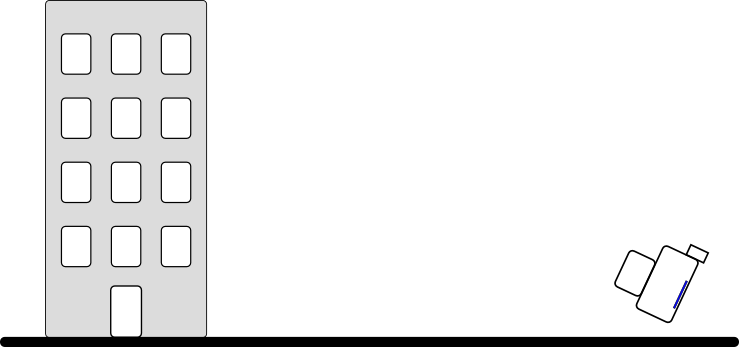

Heredando de la época de película, dónde el sensor de autoenfoque no podía estar delante de la propia película, los fabricantes de cámaras digitales tipo réflex optaron por el montaje de sensor de autoenfoque como se muestra en la siguiente figura.

Cuando el espejo está bajado, una pequeña zona del mismo es semitransparente, lo cual permite que parte de la luz viaje hasta el sensor de autoenfoque (gracias a un segundo espejo) que reside en la parte inferior del habitáculo del sensor/espejo de una cámara digital. Cuando se hace la foto, la combinación de espejos se levanta en conjunto y la luz en su totalidad llega al sensor, ya sea película o digital. Por eso hasta hace muy poco (ver la parte de sensores híbridos) era imposible usar un el sistema de autoenfoque por detección de fase cuando una cámara réflex estaba en liveview.

Como pequeño detalle, indicar que habitualmente estos sensores de autoenfoque (hay uno por cada punto de autoenfoque que tenga nuestra cámara) suelen ser horizontales, lo cual hacen que se detecten mejor las características verticales (según leo, las imágenes tienden a contener más características verticales que horizontales). De todas formas, desde hace unos años, algunas cámaras incorporan un sensor vertical que cruza algunos de los horizontales para darle mayor precisión al mecanismo de enfoque, es lo que habitualmente se conoce como puntos de autoenfoque en cruz.

Problemas de esta solución

Esta solución, aunque es la más usada por las cámaras profesionales, tiene sus desventajas. Empecemos por la más agravante de todas: falsos positivos. Dado que el sensor de autoenfoque no está colocado en el mismo plano que el sensor, o sobre el sensor mismo, si el sistema no viene bien ajustado de fabrica podemos tener problemas de calibración, donde veamos que para algunas lentes enfoca bien pero para otras no.

Para solventar este problema, las cámaras modernas suelen venir con un menú especial donde se puede especificar la corrección para cada lente que tengamos, habitualmente usando un sistema como LensAlign para conseguir un perfecto calibrado.

Sí os acordáis de la explicación de como funcionaba el sistema de autoenfoque por detección de fase, había comentado que lo que utiliza es rayos de luz proveniente de puntos diametralmente opuestos de la lente, donde habitualmente intentan que sea lo más lejos del centro de la lente posible. Por este motivo muchas veces vemos que para la cámara X algunos puntos de autoenfoque solamente funcionan a f2,8, o f4… etc. Cuanto más cerremos la lente, más probable es que estemos tapando la zona de la lente que usa el sensor de autoenfoque para determinar lo enfocada o no que esté una lente.

Detección de fase en el sensor digital – Sistemas híbridos

Desde hace unos años hasta la actualidad estamos viendo dos “revoluciones” en términos de cámaras fotográficas. Por un lado las cámaras sin espejo parece que por fin están empezando a ganar mercado de forma decisiva sobre las tradicionales réflex, y por otro lado tenemos la revolución del vídeo con cámaras fotográficas.

Las cámaras sin espejo obviamente no pueden usar un sistema de autoenfoque por detección de fase como el mostrado en la sección anterior. Al mismo tiempo, cuando una cámara réflex está grabando vídeo, el espejo está levantado, por lo cual no llega luz al sensor de autoenfoque. Por estos motivos los fabricantes de cámaras han terminado montando los sistemas de autoenfoque por detección de fase en el propio sensor digital.

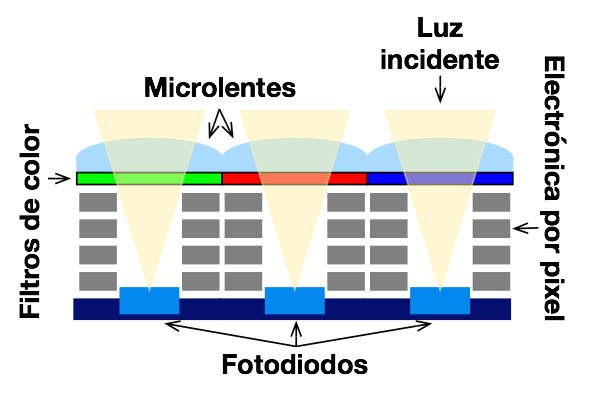

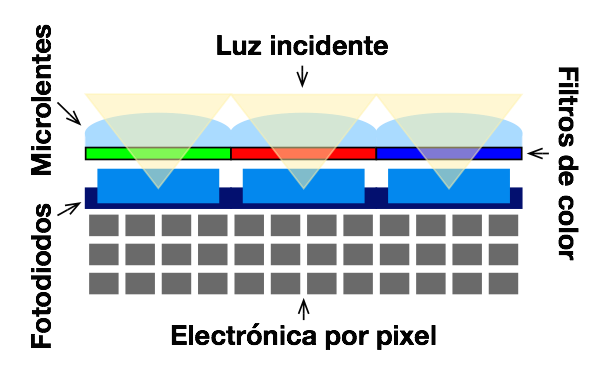

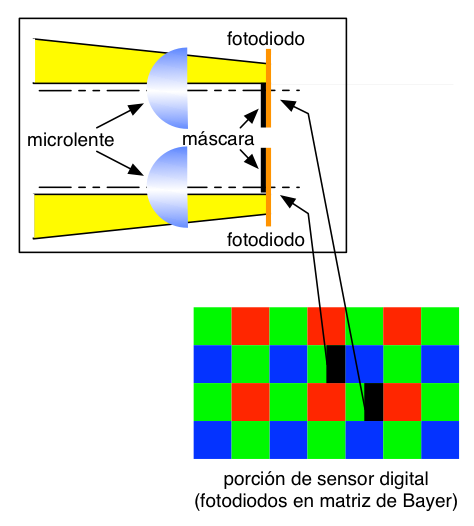

Con el aumento de los megapíxeles en las cámaras, para conseguir que los sensores de luz cada vez más pequeños recibiesen igual o mismo luz que el mismo sensor pero con menos megapíxeles de la generación anterior, los fabricantes de cámaras desde hace unos años han empezado a poner pequeñas microlentes encima de cada fotodiodo de los sensores.

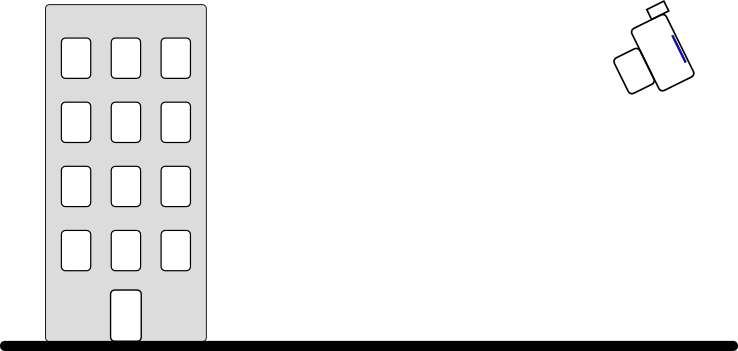

Aprovechando esto los fabricantes de cámaras digitales consiguen crear en el propio sensor de forma relativamente sencilla un detector de autoenfoque por detección de fase. La siguiente figura presenta más o menos la estrategia “típica” (y va entre comillas por que aquí todavía no hay tanta información por internet como para el sistema tradicional, la única excepción que conozco hasta el momento la explico más adelante en una sección particular).

Como ya expliqué anteriormente, un sensor de detección de autoenfoque por detección de fase se basa en que el sensor reciba la luz de dos partes diametralmente opuestas de la lente. Para ello, justo detrás de la microlente que hay sobre el fotodiodo (habitualemente en un sensor con una matriz de Bayer se usan píxeles de color verde), se pone una máscara que tape la mitad de la luz que llegue al fotodiodo, y en el fotodiodo adjacente, se hace lo mismo, pero se tapa la mitad opuesta.

Para cada punto de autoenfoque los fabricantes usan más de dos píxeles para obtener mayor precisión. Cada píxel usado para esta tarea recibirá el 50% de la intensidad de la luz que sus píxeles vecinos. Básicamente verán peor. Los fabricantes de cámaras aseguran que la cantidad de píxeles para estos menesteres es ínfima comparada con el número total de píxeles del sensor. Por algoritmos de software los fabricantes son capaces de recuperar la información perdida hasta cierto punto y realmente nadie es capaz de notar la diferencia.

Este tipo de sistemas se denomina híbrido por que a parte de hacer detección de fase, el algoritmo de autoenfoque puesto del fabricante también puede usar en combinación detección de autoenfoque por contraste para refinar los resultados.

Canon Dual Pixel

Canon decidió ir por otro camino para implementar su sistema de autoenfoque por detección de fase en el sensor, que explican bastante bien en un artículo en su página web.

La idea es bastante sencilla, cuando decimos que un sensor tiene 20 Megapixeles (por decir una cifra), lo que tiene realmente son 20 millones de microlentes que por debajo tienen 20 millones de fotodiodos (simplificando mucho las cosas). Canon lo que hizo fue dejar esos 20 millones de microlentes, pero por debajo puso 40 millones de fotodiodos (realmente la cifra es inferior, dado en los bordes del sensor se usan los típicos fotodiodos de toda la vida, es decir, una microlente, un fotodiodo). Entonces por cada microlente tenemos dos fotodiodos (de ahí el nombre de Dual Pixel).

De esta forma cada “píxel” del sensor es capaz de medir la luz proveniente de cada lado de la lente y esta medida ser empleada por algoritmos de detección de autoenfoque por detección de fase. Una vez el usuario está listo para tomar la foto, lo que hace el software de la cámara es medir la luz en ambos fotodiodos y sumarla para crear la medida final para crear la hipotética imagen de 20 Megapíxeles.

La principal ventaja de este sistema es que no tenemos ningún píxel que pierda la mitad de luz como en el caso anterior.