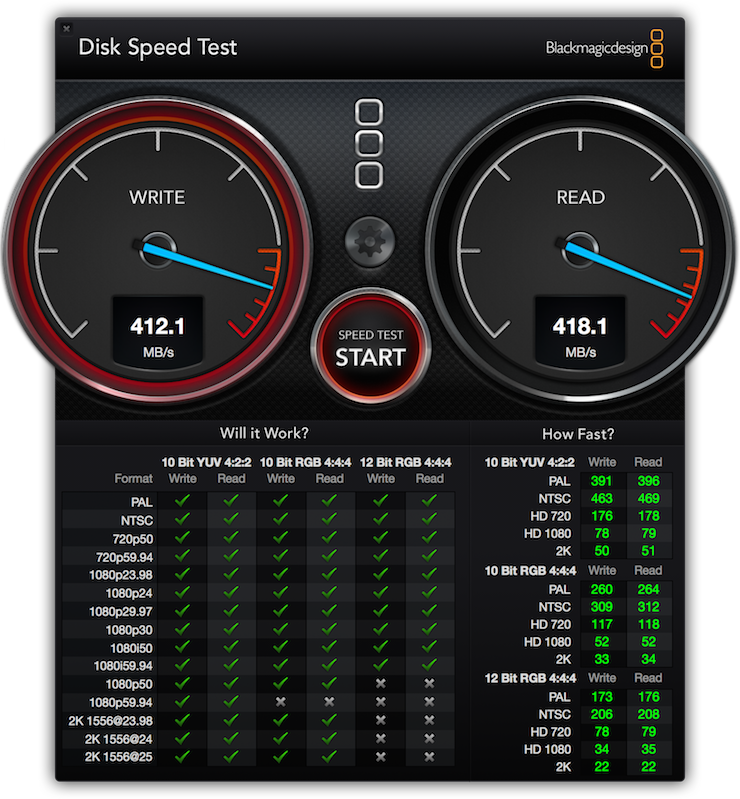

Este artículo no va a ser una discusión banal sobre sí la tecnología CCD o CMOS es la superior. Dicha discusión a mediados del 2015 ya no tiene sentido. El mayor fabricante de sensores digitales, Sony, anunció a principios de año que dejaba de aceptar más pedidos para sensores de tipo CCD, claramente indicando que dejaban de fabricarlos. Pocos fabricantes usan hoy en día sensores CCD, las excepciones las encontramos en respaldos digitales de medio formato, como los de Phase One ó en algunas cámaras de vídeo como las de Blackmagic.

Amanece en Benijo [Canon 5D Mark II con Canon EF 17-40 F4L . Toma sacada a IS0100, f11 y 0,6 seg. Trípode

. Toma sacada a IS0100, f11 y 0,6 seg. Trípode

y disparador remoto utilizado]. © David García Pérez 2015.

utilizado]. © David García Pérez 2015.

Más adelante durante el artículo explico por que CMOS está triunfando en cuanto a número de cámaras que incorporan esta tecnología versus CCD. ¿Significa que CCD poco a poco desaparecerá? Puede… hace 20 años nadie daba un duro por CMOS (una afirmación un pelín exagerada…), puede que futuras evoluciones de la tecnología le vuelvan dar otra oportunidad al CCD o tal vez aparezca algo nuevo que jubile a ambos.

Nacimiento de los sensores digitales

La historia de los CCDs es bastante antigua. Fueron inventados en el año 1969 por Wilard Boyle y George E. Smith en los laboratorios de AT&T Bell Labs. Bautizaron a su invento Charge Bubble Devices. La idea del invento era sencilla, era un dispositivo capaz de leer una serie de valores de carga de un array uno a uno y convertirlos en señales digitales. La idea, según sus autores, tenía bastantes aplicaciones, tales como memoria o dispositivo para capturar imágenes. La primera patente aplicada para ser usada como sensor para imágenes sería Michael Tompsett en 1971. Su dispositivo era un sensor lineal de 8 píxeles que era capaz de actuar como escáner. Era el comienzo de la imagen digital, por el camino el nombre cambiaría a Charge Coupled Devices (CCD). Boyle y Smith recibirían el Premio Nobel de la física por este invento en el año 2009.

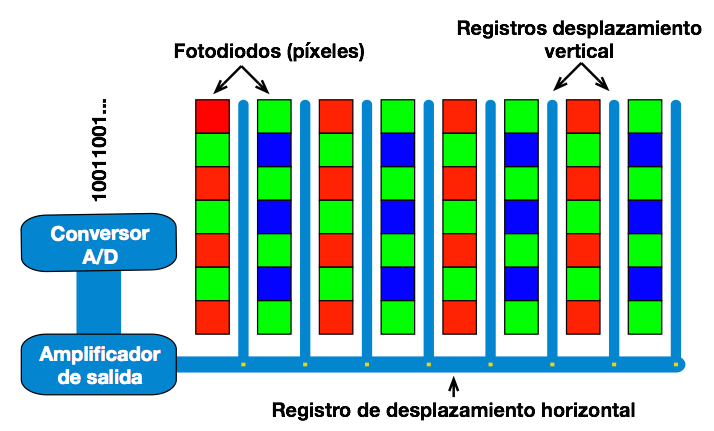

El funcionamiento de un CCD actual se puede observar en la siguiente figura:

Por un lado tenemos los fotodiodos, estos son las partes que reciben la luz, y la convierten a una carga de electrones que es almacenada en el propio pixel. Una vez hecha la captura la carga de cada pixel es transferida una a una fila a fila a los registros de desplazamiento vertical. Y cada fila es después transmitida al registro de desplazamiento horizontal. Pixel a pixel el amplificador de salida convertirá esa carga de electrones en una señal de voltaje analógico que después será convertida a una señal digital por el conversor analógico-digital (A/D).

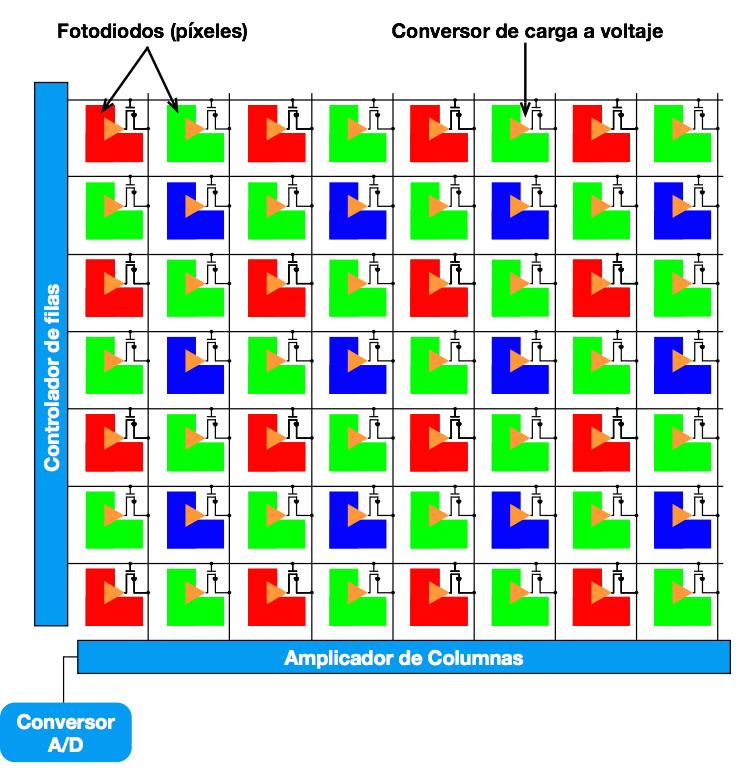

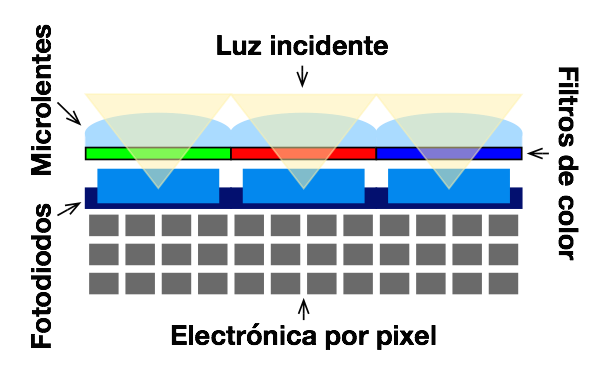

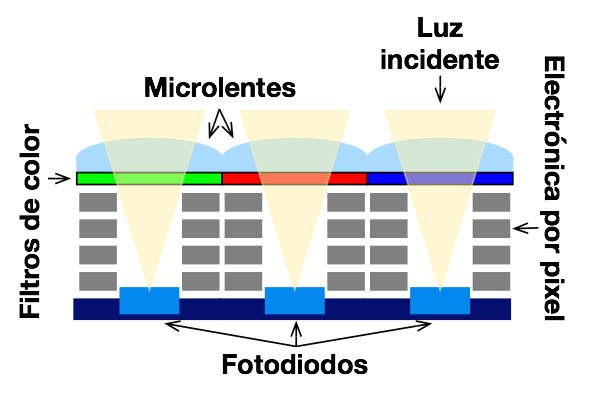

El otro tipo de sensor digital que se ha popularizado a lo largo de los años son los conocidos como sensores CMOS. A diferencia de los CCD, estos no reciben el nombre por como funcionan, sino por el tipo de proceso de fabricación que siguen: semiconductor complementario de óxido metálico o complementary metal-oxide-semiconductor (CMOS), que es la misma tecnología que se usa para fabricar cualquier tipo de microchip hoy en día (un detalle que resultará relevante más adelante). Un esquema muy simplificado del mismo es el ilustrado por la siguiente figura:

La primera diferencia que vemos aquí con respecto del CCD es que dentro de cada pixel o fotodiodo está la electrónica que convierte esa carga de electrones que se crea cuando incide luz sobre el sensor en una señal de voltaje analógico. Voltaje que será después convertido por uno o varios conversores A/D en una señal digital.

Evolución

Como muchos sabréis, hasta hace unos años casi todos los sensores fotográficos eran del tipo CCD. Y sobre el 2000 parecía raro que esto fuese a cambiar (y cambió, de forma muy rápida). Los sensores CCD tenían una serie de ventajas inherentes a su diseño. De entrada no tienen que acomodar electrónica dentro del propio pixel como los CMOS (hay una excepción explicada más adelante), lo cual hacía que cada pixel pudiese recibir más luz, mejor señal, menos ruido. También era más fácil en los mismos aplicar lo que se conoce como obturador global (global shutter) a nivel electrónico, que evitaba el efecto conocido como rolling shutter (este efecto también se podía dar en película, dependía de como el obturador de la cámara estuviese implementado). No es que en un sensor CMOS no se pueda implementar un global shutter, sencillamente que es muchísimo más complejo.

También existe la creencia de que los sensores CCD producen mejor color que los CMOS. Realmente esto es debido a que los sensores de cámara de medio formato (hasta hace muy poco prácticamente todos CCDs) tienen un mejor filtro bayer que las cámaras CMOS de 35mm (esto también tiene un precio, cuanto más preciso es el filtro en diferenciar rojo, verde y azul, menos luz llega al fotodiodo y más ruido puede haber).

Pero los sensores CCD tienen una gran desventaja, su proceso de fabricación es distinto a como se fabrican los microchips. El principal inconveniente de esto es que no se beneficia directamente de los avances de procesos de fabricación de microchips. Al mismo tiempo, requieren que la electrónica para convertir la señal a digital vaya en un chip a parte, lo cual hace más voluminoso el resultado final. Además, también consumen más energía que su equivalente CMOS. Estos dos últimos puntos muy importantes si estás fabricando cámaras para móviles, por ejemplo.

Como indiqué más arriba, los sensores CMOS se beneficiaron en gran medida de la evolución de las tecnologías para fabricar microchips, que siguen exactamente los mismos procesos de fabricación que los que llevan este tipo de sensores. Hasta ahora el proceso de fabricación de microprocesadores se ha guiado por la famosa Ley de Moore, que en algún momento se topará con los límites de la física. Esta ley dice que la cantidad de transistores en un chip se duplicará cada dos años. La principal manera de conseguir esto es a través de hacer dichos transistores más pequeños. Esto tiene la ventaja de que los transistores encargados de hacer la transformación de carga a voltaje que ocupaban parte del pixel, cada vez es más pequeña, y tapan menos área que reciba luz (también hay que tener en cuenta que cada vez los sensores tienen más megapixeles, así que se va manteniendo un equilibrio sobre cuanto ocupa dicho lógica dentro del propio pixel).

Al mismo tiempo, otras de las desventajas fueron cayendo poco a poco. Los sensores CMOS cada vez mostraban mejor relación señal-ruido con lo cual podía alcanzar ISOs más altos sin pérdida de calidad. Un detalle donde CCD sigue manteniendo ventaja es en el tema del global shutter, es mucho más fácil de implementar a nivel electrónico en un sensor CCD que en uno ��������������������CMOS.

Actualidad y futuro

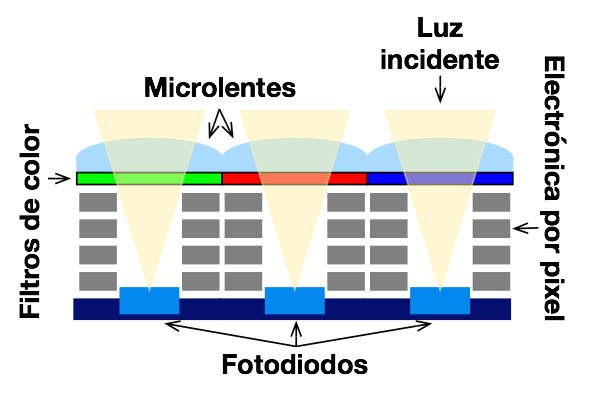

Si estáis siguiendo últimamente la actualidad de cámaras nueva que salen al mercado os habréis dado cuenta que la norma es cada vez más megapixeles. Sin entrar en el eterno debate si realmente hace falta más megapixeles (tengo que la teoría que el mínimo necesario que todo el mundo dice que hace falta cambia con los años). Este incremento en el número de megapixeles ha disminuido el área de los mismos, por lo cual cada pixel recibe menos luz. Ya hace tiempo que todos los pixeles tienen una microlente encima que les ayuda a recibir más luz para así contrarrestar un poco su área más pequeña. Pero ahora surge un problema con el tamaño del pozo. Si nos fijamos en esta figura sobre un supuesto corte vertical de un sensor CMOS:

Como se observa en el diagrama anterior, la electrónica necesaria por pixel CMOS hace que la zona fotosensible esté más profunda de lo deseado. Esto implica que la luz tiene que entrar muy directa sobre el sensor, lo cual es un problema para lentes de gran angular. Por este motivo se coloca desde hace bastante tiempo microlentes en frente de cada pixel, para intentar mejorar la cantidad de luz que recolecta cada pixel.

La primera vez que escuché hablar de este problema fue cuando salió [el respaldo digital de Phase One IQ180] (que curiosamente es CCD, su problema es que son 80 megapixeles, lo cual hace el tamaño de pixel muy pequeño). Para ciertos tipos de lente este mostraba zonas de color púrpura en los bordes de la imagen y fuertes viñeteos, debido a que la luz que salía de una lente gran angular no llega al sensor con un ángulo de 90 grados, sino inclinados y no toda la luz llegaba al fotodiodo por culpa de ello.

Este es el mismo problema por el qué se dudaba, al principio, que la serie A7 de Sony pudiese tener grandes angulares (grandes “expertos” en foros de internet lo dudaban). Al montarse la lente mucho más cerca del sensor (al no tener espejo), es muy complicado hacer un diseño de gran angular que no resulte muy voluminoso (se necesitaría un diseño de retrofocus para enderezar al final los haces de luz, lo cual, además de añadir elementos ópticos que pueden hacer perder calidad, hacen la lente mucho más grande) (supongo que la lente 16–35f4 de Sony para su montura FE hizo que estas especulaciones desapareciesen, al menos para un sensor de 36 Megapixeles como el de la A7r).

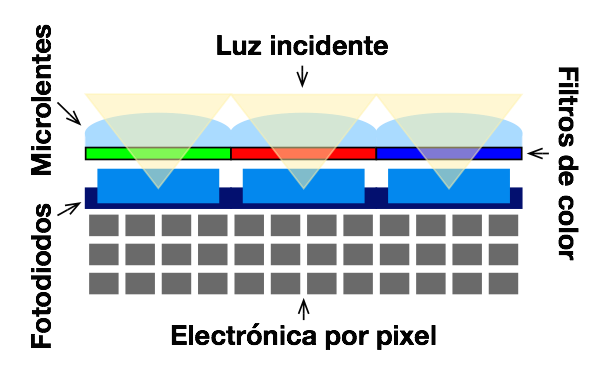

Pero el problema sigue estando ahí, cuantos más megapixeles menos luz recibe cada pixel. Curiosamente este ha sido un problema que ya se enfrentaron las compañías fabricantes de sensores para telefonía móvil, como Sony y Samsung. Para solventar dichos problemas, se introdujo un nuevo diseño de sensor denominado Back Side Iluminated CMOS. El esquema más o menos sería el siguiente:

La idea más sencilla no puede ser. Se trata de poner la zona fotosensible lo más cerca posible de las microlentes y toda la electrónica necesaria para que cada pixel funcione debajo. La idea es sencilla pero supongo que el proceso de fabricación es mucho más complicado que los típicos chips CMOS para que no empezase a verse en las cámaras hasta hace poco. De esta forma la luz recolectada por el fotodiodo es mucho mayor, haciendo posible de que a pesar de que el tamaño del pixel sea más pequeño (por la gran cantidad de megapixeles), este siga recibiendo suficiente cantidad de luz para que la relación señal ruido siga siendo buena.

Hay que entender como funciona el proceso de fabricación de un chip. Los chips se hacen en obleas de silicio, en cada oblea se van construyendo por diversos procesos físicos y químicos los chips, una vez se finaliza el proceso, la oblea se corta y salen el número correspondientes de chips que cogiesen en esa oblea. Esos chips se testean, dado que un fallo en el proceso de fabricación o impureza en los materiales como la propia oblea de silicio pueden hacer que el chip vaya directamente a la basura. Cuanto más pequeños sean los chips, más te cogen por oblea, así que el ratio entre chips que salen buenos o malos aumenta. Cuanto más grande sea el chip, la probabilidad de que te salga mal algo aumentan significativamente (por eso un sensor de full-frame es mucho más caro que un sensor de móvil).

Los sensores de teléfonos móviles son bastante pequeños, debido a ello nuevas tecnologías que requieran procesos de fabricación más complicados se testean en ellos, como es el baso de BSI CMOS. Cuando el fabricante considera que el proceso de fabricación es lo suficientemente maduro y dicha tecnología puede beneficiar al producto final, este es portado a sus hermanos mayores.

El primer fabricante en sacar una cámara con lentes intercambiables y sensor BSI CMOS fue Samsung con su NX1. Sony, con su A7r II ha sido el segundo, pero de esta vez con un chip de tamaño full-frame y 42 megapixeles. En una entrevista reciente, uno de los responsables de la división de Sony para cámaras comenta que hasta llegar al nivel de 42 megapixeles en el sensor no sintieron la necesidad de portar su tecnología BSI CMOS a las cámaras. En este caso, al ser el pixel tan pequeño, la única forma que veían de conseguir un nivel de ISO aceptable y comparable con modelos anteriores, era usando BSI CMOS (también indican que cambiando de aluminio a cobre en el proceso de fabricación les ayudó a reducir ruido en las etapas de amplificación de la señal). Curiosamente las nuevas Canon 5Ds y 5Ds R que usan tecnología CMOS típica, tienen el ISO limitado a 6400.

Desde que el mundo de sensores digitales se aplica a la fotografía “profesional” no han pasado ni 20 años y parece que las innovaciones y mejoras no paran de llegar…

: